Google发布了网页统计报告,来源于他们索引的42亿个网页(PageRank高的网站占的权重可能会比较高):

閱讀全文

標籤彙整: seo

《法治周末》:百度竞价排名愈演愈烈 被指搜索结果不公有违诚信

谷歌退出中国市场后,中国搜索引擎市场的格局将发生怎样的变化?有专家指出,谷歌退出后,百度的市场份额必定会进一步增加,很可能 会涉嫌垄断.另外,百度 独大的局面,也会助长其经营中诸多不规范的行为,对于这种打法律“擦边球”的行为,专家认为应当通过立法加以规范在 谷歌退出中国内地两个多月之后,人民网于近日推出了自己搜索引擎——人民搜索,并称要“建立具有权威性的综合中文搜索引擎”和“提供具有公信力的搜索结 果”,再次引发了业界关于搜索引擎市场格局的思考. 閱讀全文

《中国青年报》:百度竞价排名属什么性质

如果一个老板,想把自己足球队的联赛排名提高,给裁判或足协官员送钱,结果会怎样呢?这样的裁判或足协官员会被请去“喝茶”,甚至 被抓起来。

但如果一个老板,想把自己企业在搜索引擎上的排名提高,而送钱给百度,结果会怎样?到目前为止,什么也不会发生。出钱把自己企业在搜索 引擎上的排名提高, 叫竞价排名。竞价排名是百度一直坚持的商业模式,即使被解释为“按效果付费的网络推广方式”,除了在原有的竞价排名外,加入了按点击付费,实质仍没有变 化。 閱讀全文

Google搜索:实时搜索算法仍需优化

新闻来源:google.org.cn

Search Engine Land主编参加了TWTRCON大会,今天主办方David Berkowitz邀请来了Google(谷歌)搜索产品经理Dylan Casey跟大家谈谈实时搜索。

问:为什么实时搜索结果对Google用户来说是重要的? 答:对于一个发布平台来说,内容是重要的。所以我们先是加入了对博客的支持,之后是微博客。其意义并不在于一个URL地址,更在于这些元数据和 信息可以帮助我们理解网页内容和意义。这些内容都从何而来?它们之间关联如何?这就是为什么使得他们跟Google和用户是相关的原因。 閱讀全文

德法院称谷歌图片搜索使用缩略图不侵犯版权

德国联邦司法法院今天驳回了一名艺术家的起诉,称谷歌使用“缩略图”图像不侵犯其版权。这名艺术家将作品的照片发布到其网站上,并 使之能够被搜索引擎索引。

德国联邦司法法院称,谷歌“可以认为原告的行为表明其同意在图像搜索服务中使用作品图像。原告没有采取技术措施,阻止搜索引擎索引其网站内容 并显示作品图像”。这名艺术家指控谷歌在图像搜索服务中显示作品的缩略图侵犯了其版权。两家级别较低的法院已经驳回了其诉讼。

这一诉讼彰显出对互联网公司未经授权使用版权内容的争议。谷歌等网站使消费者能更方便地分享版权内容,促使艺术家、出版商和体育组织纷纷加大了 版权保护力度。

德国联邦司法法院指出,只有在第三方未经授权擅自发布作品照片,而且谷歌知情的情况下,谷歌才需要承担侵犯版权的法律责任。

Matt Cutts 回答关于 Google 搜索算法问题

我们可爱的一休哥Matt Cutts又回来了。在最新放出的视频中,他回答了两个关于Google搜索算法的问题。

第一个问题是:在2009年中,Google一共对其搜索算法修改了多少次?

Matt Cutts的回答是350到400次,平均每天一次还多。

对于每天都使用Google Search的你是否有点惊讶这个数字呢?Matt Cutts继续解释道:有些算法的改进只是小修小补,比如能够更好的适合某国语言,能够更快的同步,所以Google并不一定将所有的更新都进行发布。 閱讀全文

南都周刊:后Google时代的搜索战场

除了死敌微软、百度之外,网易、腾讯、搜狐这些二线梯队都或明或暗地采取着行动,伏在其后的“国家队”却早已蓄势待发。在 张朝阳看来,Google的出走 为众多搜索引擎提供了发力的新战场,这场新游戏的主角不仅有Google的国际对手微软bing,中国死敌百度, 包括搜狗在内的中国二线搜索梯队同样有发力的空间。 閱讀全文

Google将访问速度纳入搜索排名考量

Google对于网络搜索的排名有着极为复杂的算法,今天他们宣布,网站的速度也将成为搜索排名的新因素。

Google认为,网站和网页加载迅速,可以让用户节省下时间并且观感更好,这也符合Google的经营理念,不过需要注意的是,速度并不是最主要的排名 因素,“相关性”在排名中的主导作用依然不会改变,速度对搜索结果的影响程度应该不到1%。< 閱讀全文

谷歌为其排名系统进行辩护 称有时会人工修改

针对谷歌有时会人为干预其自动排名的最新质疑,该公司周四对其搜索引擎的工作方式再次进行了辩护。

早先,布鲁塞尔针对来自三家公司对谷歌的投诉,调查谷歌是否在搜索排名和相关广告处理方式上,不公平地对待一些竞争对手。谷歌一名负责排名系统的员工 Amit Singhal周四在一篇博客中称,相对于人为干预的排名结果,按照谷歌的算法产生的排名结果质量和相关性都更高。但是他也坦承,谷歌的系统远非完美。

谷歌其他高管本周也不遗余力地强调谷歌排名系统的“非人工”性质,试图说服批评者,谷歌在搜索结果中既不会偏袒某些网站,也不会刻意置它们于不 利。谷歌欧洲高级竞争顾问朱莉娅•霍尔茨(Julia Holtz)周三在布鲁塞尔告诉媒体:“我们从不搞‘白名单’或‘黑名单’。”

但是,周四出现的最新证据显示,谷歌员工有时的确会对其系统进行干预,起码在其关键词广告这块业务中。这项业务理论上是通过自动计算来决定广告在搜索结果 中出现的位置。

向布鲁塞尔投诉谷歌的公司之一,英国价格比较服务网站Foundem,出示了两封看上去是来自谷歌Adwords员工的电子邮件,其中讨论了“白名单”做 法,也就是通过改变系统以改进某一个搜索结果的排名。

一位谷歌发言人拒绝就Foundem的申诉进行评论,但是承认说,谷歌有时会人为修改搜索结果的排名,以减少计算结果被扭曲的现象。这位发言人没有透露这 样的修改发生的频率有多高,只是说很罕见。

利用网站管理员工具进一步诊断您的网站

原文:Advanced Website Diagnostics with Google Webmaster Tools

发表于:2008年9月30日星期二,上午11: 07

运营网站是一件很复杂的事情,所以我们提供了网站管理员工具来帮助您发现潜在的问题,并防止它们演变成真正的问题。这些发现的问题中,有一些相对来讲比较小(比如有重复的标题和描述),但也有一些是比较大的问题(比如我们无法访问您的网站)。尽管网站管理员工具无法确切地告诉您需要做哪些具体的改动,但是它可以帮助您发现一些需要您解决的潜在问题。

让我们来看一下我们在网站管理员支持论坛里碰到的几个例子:

您的服务器是否把Googlebot当作普通的网站访问者?

尽 管Googlebot尽力表现的像一个普通用户,但有一些服务器可能还是会感到困惑而以比较奇怪的方式进行回应。比如,当用户以Googlebot为 user-agent进行访问时, 虽然您的服务器在大多数时间里都可以完美无暇地工作,但是有一些运行IIS的服务器会返回服务器错误(或者其他一些和发生服务器错误相关的操作)。在网站 管理员支持论坛里,我们曾经碰到过IIS服务器返回500错误(服务器错误)和404错误(文件找不到)出现在“网络抓取”诊断部分的情况,还有提交网站地图(Sitemap)文件时出现302错误。如果您的服务器重定向到错误页面,您应该确保我们可以抓取这个错误页面,并且确保服务器返回正确的错误代码。当您做好这些以后,我们就可以在网站管理员工具里显示这些错误。如果您想了解关于这个问题的更多信息及可能的解决方法,请参阅:

http://todotnet.com/archive/0001/01/01/7472.aspx 和http://www.kowitz.net/archive/2006/12/11/asp.net-2.0-mozilla-browser-detection-hole.aspx。

如果您的网站托管在运行Microsoft IIS的服务器上,请记住,自然情况下网址是区分大小写的(我们也是如此处理他们的)。这包括那些出现在robots.txt文件里的网址。如果您的服务器以不区分网址大小写的形式工作,您应该小心处理这一部分。例如,“disallow: /paris”将阻止我们访问/paris,而不是/Paris。

您的网站是否存在一些系统性的已损坏的链接?

现 代内容管理系统(CMS)经常会导致一些问题,而这些问题往往能够影响大批的网页。有时候这些问题很直接,当您在浏览这些页面时就可以发现;有时候,靠您 自己很难发现这些问题。如果某个类似上述的问题产生了大量损坏的链接,它们一般会显示在您网站管理员工具帐户的“网络抓取”诊断部分(列出那些正常返回 404代码的已损坏的网址)。在最近的一个个案中,一个网站的RSS feed出了一个小的编码错误,结果导致超过60,000个坏的网址显示在该网站的网站管理员工具帐户里。您一定能理解,我们更愿意将时间花在抓取内容而不是这些404错误页面上:) 。

您的网站是否将用户导向其他地方?

许 多网站都有自己关注的特定地域的用户群。我们发现这类网站有时会将其他地域的访问者重定向到一个不同的页面。然而,请记住Googlebot不一定来自于 您期望的目标地域,所以也有可能被重定向到其他页面。这可能意味着Googlebot不能访问您的主页。如果发生这种情况的话,网站管理员工具在验证您的 网站时可能会出现问题,导致您的网站无法通过验证。当然,这不是网站无法通过验证的唯一原因,但是如果您的网站经常出现这种情况,最好还是调查一下原因。在这个问题上,请确保用对待那个地域的用户一样的方式对待Googletbot,否则可被视为“内容伪装”。

您的服务器是否在我们抓取时无法访问?

即 使最好的网站也会出现这种情况——服务器宕机以及防火墙过度保护。如果在我们试图访问您的网站时出现这种情况的话,我们就无法对您的网站进行抓取,而且您 可能不知道我们已经尝试去抓取过您的网站了。幸运的是,我们会跟踪这些问题,当我们无法访问您的网站时,您可以在管理员工具帐户里发现“网络无法访问”及“robots.txt 文件无法访问”错误。

您的网站是否被黑了?

黑 客有时候会在出问题的页面上添加些奇怪的、远离主题的隐藏内容和链接。如果是隐藏的话,您可能不会马上注意到它。尽管如此,它还是有可能成为一个大问题。 虽然消息中心会就某些类型的隐藏文本向您发出提醒,但是您最好也要多留意一些。网站管理员工具“统计信息”项目下的“Googlebot看到的内容”会显示与您网站内容有关的关键字,如果您在那里看到一些完全不相关的关键字,那么您的网站有很大可能被黑掉了,您最好能尽快调查一下发生了什么事情。您也可以使用谷歌快讯(Google Alerts)或者使用[site:example.com 垃圾关键词]进行查询,在这里“垃圾关键词”是指一些像色情, 伟哥, 曲马多(tramadol,一种镇静剂), 性及其他一些您的网站上一般不会出现的词语。如果您发现您的网站真的被攻击了,我推荐您参阅我们博客上的另外一篇帖子——我的网站被黑掉了,怎么办?

网 站管理员工具可以发现很多关于网站的问题;上述问题只是我们最近碰到的问题当中比较普通的一些罢了。因为有一些问题真的很难发现,在它们真正成为问题之前 您不妨去看一下您的网站管理员工具帐户,看看能不能发现一些问题的苗头。如果您发现一些您确实无法解决的问题,为什么不在网站管理员支持论坛上发贴来寻求专家们的帮助呢?

今天,您检查您的网站了吗?

李彦宏:不应为信息真实负责

周三,百度召开分析师电话会议.掌门人李彦宏表示,百度希望做一个负责人的企业公民,但是他同时认为搜索引擎不应该为互联网信息真实性负责.

美联社评论指出,央视曝光虚假搜索广告事件对于百度来说是一个巨大的挫折.李彦宏在电话会议上表示,百度正在要求药品等广告主提供相关资质证明,借此取得 网民信任.据美联社说,李彦宏同时强调,提供广告主资质并非中国法律要求,另外搜索引擎或许不应该为网络信息真实性承担责任.

美联社引述李彦宏说:“我们这么做是因为我们重视,这对于百度很重要,我们希望做一个负责任的企业公民.”

李彦宏表示,短期之内,百度的访问流量将会受到负面影响.

美联社指出,和Google中国不同,百度的搜索广告混杂在搜索结果中,结尾只有一个很小的“推广”,网民不知道这是搜索结果还是广告.而Google中国网站则是将顶部的广告放在一个有颜色背景的区域中,网民一看就知道这是广告而非搜索结果.

百度“竞价排名”的好坏

近日有媒体报道,有政府网站参与了“百度竞价排名”.只要在百度上输入“政府网站”关键词进行搜索,该政府网址就可以排在搜索页面的最上方,而在此招出笼之前,该网址绝对没有问鼎机会.报道称,该网站为此向百度支付了5600元“竞价费”. 此事一出,立刻引发网友们的质疑.大部分网友认为:花钱买曝光率,这样的政府网站缺乏公信力.在舆论的压力下,“河北省人民政府”网站取消在百度上的“竞价排名”.

在笔者看来,政府网站的做法固然值得商榷.但是百度的“竞价排名”商业模式更值得我们思考.

所谓“竞价排名”是一种可以把点击率转化为商业收入的营销方式:根据商家出价的高低,来决定搜索结果的排名先后.有资料显示,65%—70%的网民在点击搜索结果时,只会选择前10条,针对性强的产品关键词能将潜在客户直接带到产品介绍页面.

百度作为一家企业,利用“竞价排名”的商业模式营利,本无可厚非.但是百度不能忽略的是:企业要想获得长期发展,首先是产品能够得到消费者的认可.

商家是否参与“竞价排名”的根据是网友对百度的点击率,而点击率取决于百度的搜索结果能否给网友带来良好体验.但目前的现实是,“竞价排名”的商业模式使 得百度搜索结果出现了过多的“推广”页面,如对“白酒”、“心脏病”等词语的搜索,首页全部为推广页面,这大大限制了用户的搜索结果,并降低了用户的搜索 体验.如果失去由用户良好体验所带来的网站流量,百度的获利将变成无源之水.

更为重要的是,搜索引擎是互联网的“窗口”,它的影响是巨大的.最先它控制了人们获取什么样的信息,然后控制人们消费什么样的商品,最后可能会诱导人们的 思想、影响人们的行为.在美国,搜索是一种社会工具,行业自律制度规定:搜索引擎公司有责任将搜索页面上的广告与新闻标志清晰明白.但在中国,对搜索引擎 的监管尚处缺位状态.但是从长期来看,中国对搜索引擎业类似的监管一定会跟进,而这将给百度带来一定的危机.

百度应该好好思考一下,如何在用户体验和商业利益间找到平衡.毕竟,创造一种成功的商业模式不容易,还需要用心呵护.而对于那些对百度商业模式跃跃欲试的中国中小网站来说,现在应该更清楚,从百度身上该学什么,不该学什么.

百度:日封三万个垃圾网站

11月13日,谷歌总裁李开复在“搜索,未来”互联网主题论坛上表示搜索引擎的结果应当基于公正性.百度公司也对外表示:“妨碍搜索引擎公正性的首要问题是垃圾信息”.

百度发言人表示,中文互联网的垃圾信息泛滥已成为了一个非常严重的问题:“ 由于搜索引擎已经成为了互联网的入口,在搜索引擎上排名的高低,可以产生巨大的 商业价值,于是大量的垃圾信息在互联网上滋生,目的就是通过搜索引擎获得商业利益.但这些垃圾信息,严重影响了人们正常使用搜索引擎.如果搜索引擎不能解 决好这个问题,受害的是广大网民,并最终伤害搜索引擎产业的未来.”

据百度介绍,百度每天处理的作弊及垃圾站点数 量,大约在3万左右.“数量庞大的垃圾信息制造者每天在制造数以万计的垃圾网站,这些网站包括纯作弊网站、机器采集网站、钓鱼网站等”.百度发言人表示, 这些作弊站点的目的就是为了从搜索引擎获得流量,百度投入了巨大的资金和人力去跟他们进行战斗,“ 每年在反垃圾信息领域的技术投入,超过了全球中文搜索引擎市场的总和”.

“目前与垃圾信息制造者的斗争已不仅仅是一场技术战争这么简 单了.”百度发言人对记者说.近日对百度提起申请罚款1.7亿元的“互联网第一垄断案”原告全民医药网,就被网友指认是一家作弊网站.对此百度进行了确 认,并提供了数十个全民医药网作弊的页面链接.记者发现,这些页面充满了没有什么意义的文字,但仔细一看,文字都被内置了指向全民医药网的链接.百度表 示,“该网站确实被我们认定为有群发垃圾信息和恶意链接的作弊行为”.

“垃圾信息制造者无孔不入”,一位业内人士表示,现在甚至到了被搜索引擎封杀后,又来炒作吸引媒体眼球,实际最后的目的还是流量.网站有流量就能实现商业利益.

由于巨大商业利益驱使,互联网上垃圾信息的增长速度远远高于有价值的网页增长速度.如果搜索引擎不能打赢与垃圾信息的这场技术战争,搜索产业就会被垃圾信息摧毁.“我们号召谷歌和我们一起,共同打一场和垃圾信息做斗争的技术战争.”百度发言人表示.

百度遭遇中国网络反垄断调查第一案

受河北唐山人人信息服务有限公司法定代表人王冠珏的委托,北京市邦道律师事务所李长青律师,把一册厚达91页16开本的《反垄断调查申请书》,送到 了国家工商总局反垄断处一位官员手中,申请对百度滥用市场支配地位的反垄断调查。据这位官员告诉他,这是反垄断法实施以来,发生在网络领域的第一例。 企业向国家工商总局申请对百度滥用市场支配地位进行反垄断调查,并处1.7亿元罚款. 2007年初,曾有10年经营药品生意的唐山人王冠珏,在工商局登记注册了唐山人人信息服务有限公司,创办了一个普及医药知识及招商的网站———全民医药网。 閱讀全文

了解百度收录过程 让你的网站快速被收录

关于百度收录问题,网上有很多的相关介绍,说得百度是天花乱坠,有说百度好的,也有抱怨百度的,甚至有的还大骂出口。呵呵,我个人认为百度是中国个人站长的心脏,站长的喜悦悲哀都由这个心脏来决定。难道不是吗?

今天封尘也跟大家讨论一下百度的收录问题,主要的讨论话题是“百度收录过程”与“新站如何快速让百度收录”。这两个话题可以算是比较敏感的话题 了,都是一些SEO专业人士的主题曲。我今天讨论这两个话题并非代表我就是SEO专业人士或者什么高手之类的,只是借凭着自己两年多来的建站经验作个自我 观点介绍罢了。

百度收录过程

对于一个新站来说,从网站上线和提交到百度后到什么时候收录,是每个站长日日夜夜关注的问题。特别是新站长,当网站正式提交到百度后,每一天至 少两次查询百度对自己的新站收录情况,甚至连做梦都想着百度。但是这样的期盼往往让很多新站长失落,因为普遍的所谓真正收录实在是太漫长了。三天不收录我 可以等到第六天,第六天还不收录我可以等多一个第六天。然而二六等于十二再加三就是十五,足足的半个月时间还没收录!呵呵,这个时候难道你不感到失落吗?

当你等到第十五天的时候我可以很明确的告诉你,其实你的网站早就被百度收录了,也许是在你提交的第二天或者第三天就被百度收录了。呵呵,这话听起来是不是感觉有点假?别说听起来有点假,看起来都有点假。既然说早就收录了,那为什么我在百度搜索里连影子都看不到呢?

这个就是百度的独特之处,也是百度为什么能在谷歌与雅虎的强烈竞争中稳坐老大之席的因素之一。谷歌的收录原则是来者不拒,只要能找到的,短时间内就能在谷歌的搜索引擎中出现。

而百度则是先大量的对你网站进行索引,这个索引工具俗称“百度蜘蛛”,在IIS日志中名称为“BaiduSpider”。当你把网址提交到百度 后,“百度蜘蛛”就会在网络低潮时刻来访你的站点,大概是一天索引50条信息左右。IIS日志中可以查看到“BaiduSpider”的访问痕迹,其中主 要的有cs-uri-stem(URI资源)、cs(User-Agent)、sc-status(协议状态)。cs-uri-stem(URI资源)记 录被访问的文件名称及路径。cs(User-Agent)对应一栏中则可以看到来访者相关信息,如果是“百度蜘蛛”则显示有“BaiduSpider”字 样。sc-status(协议状态)记录着的数据主要有三个:200(成功访问)、304(已索引或未更新)、404(访问失败)。当你的网站的某条数据 有被“百度蜘蛛”访问过,并且sc-status(协议状态)显示的数字为200(成功访问),那么你的这条信息就已经成功的被收录了。如果sc- status(协议状态)显示的数字为304(已索引或未更新),就表示这条数据已经存在了。如果是404(访问失败)就说明蜘蛛无法成功访问这条信息, 这样你就应该检查一下路径了。

好,现在我简单的给大家说一下百度的收录程序:蜘蛛来访索引——蜘蛛携带已访问到的数据返回——百度服务器判断数据并且返回信息——数据入库。

当数据成功入库之后就表明已经成功收录了,但为什么在百度的搜索引擎里找不到呢?因为百度收录了你的数据后不会马上就给你放出来,要经过一系列的审核过程,当审核通过了才能在搜索引擎中出现。

说到这里也许有朋友会问?百度的审核过程也太漫长了吧?我的一个新站近一个月后才出现在百度搜索引擎中,有的甚至要两个月。据我理解,当你的网 站所有数据被百度收录到有70%左右的时候百度才开始审核你的数据。以一天收50条数据量来计算,1000条数据若要等收录到700条左右才开始审核,那 么也要近半个月的时间。所以这就是为什么有些网站需要一个月,有些网站需要两个月了。

以前有很多朋友问过我这样一个问题:比如我是这个月1号提交网址到百度,等到20号的时候百度的搜索引擎中出现了我的网站索引。但是百度快照旁边显示的时间是3号的,这是为什么呢?

其实当你了解了百度的收录过程后就不难理解这个问题了,百度快照旁边显示的时间正是这条信息的收录或者更新时间,刚才已经讲过,只要蜘蛛成功访问到的信息就是已经收录了。而搜索引擎中显示的时间就是这条信息从蜘蛛索引到入库的时间。

好了,以上就是我个人认为的百度收录过程了。

揭秘“重复内容处罚”

发表者: Susan Moskwa, 网站管理员趋势研究员

原文: Demystifying the “duplicate content penalty”

发表于: 2008年9月12日星期五,上午8: 30

重复内容始终是一个经常被谈论的话题。我们不断地发表关于这方面的文章,人们也在不断地提出问题。特别是,我还听到有很多网站管理员担心自己受到了“重复内容处罚”。

在这里请允许我们把这个问题一次性跟大家讲清楚:根本不存在所谓的“重复内容处罚”。至少,也不是大多数人谈论时所认为的那样。

有一些处罚是和抄袭其他网站的内容有关的,比如完全抄袭并且发布其他网站的内容,或者在完全没有提供任何其他附加价值的情况下发布这些抄袭的内容。这些都是我们不提倡的做法,您可以在网站管理员指南里找到有关此问题的清晰的论述:

- 请不要创建含有大量重复内容的多个页面、子域或者域。

- 请避免使用那种“一个模子印出来”(cookie cutter)的方式创建网站,比如没有或者很少原创内容的联属计划。

- 如果您的网站参与联属计划,请确保您的网站可提供附加价值。提供独特且相关的内容,使用户首先有理由访问您的网站。

(请注意,我们不希望您从其他网站那里抄袭内容,但是如果其他人抄袭了您的网站就是另外一回事了;如果您担心别人抄袭了您的网站,请您参考这篇文章)。

但 是我听到的一些担心重复性内容的网站管理员所谈论的并不是抄袭或者域名农场(domain farms);他们讨论的是诸如在同一个域上有多个网址指向相同的内容。比 如,www.example.com/skates.asp?color=black&brand=riedell

和www.example.com/skates.asp?brand=riedell&color=black。这种类型的重复性内容可能会对您网站在搜索结果中的表现有潜在的影响,但是它不会使您的网站受到惩罚。下面这段文字来自我们关于重复内容的帮助文章:

除非重复内容看起来意在欺骗用户并操纵搜索引擎结果,否则,我们不会对有重复内容的网站采取特别措施。如果您的网站存在重复内容问题,而您又未遵循上述建议,我们会自行以恰当的方式选择在搜索结果中显示的内容版本。

这种非恶意的重复是比较常见的,特别是很多内容管理系统(CMS)缺省条件下对此处理的并不是很好。因此,当人们谈到此种类型的重复性内容会影响您的网站时,并不是因为您可能会因此受到处罚,而仅仅是由于网站和搜索引擎的工作方式所造成的。

大多数搜索引擎都力求保持一定程度的多样性:他们想在搜索结果页上向您展示十个不同的搜索结果,而不是含有相同内容的十个不同的网址。为此,谷歌试着去掉重复的内容从而使用户较少看到这些多余的重复性的内容。您可以在这篇博客里了解更多的细节,其中谈到

- 当我们探测重复内容时,比如由网址参数造成的衍生网址,我们会将这些相似的网址放在同一组里。

- 我们会选择我们认为最能代表这一组的网址在搜索结果里进行展示。

- 我们还会对这一组网址的特性进行相应的整理,像链接的受欢迎程度,并将其合并到此代表性网址上。

作为网站管理员,上述过程可能会影响到您的是:

- 在 步骤二中,谷歌所认为最具有代表性的网址并不一定和您的想法一致。如果您想控制究竟是 www.example.com/skates.asp?color=black&brand=riedell 还是www.example.com/skates.asp?brand=riedell&color=black出现在我们的搜索结果中的话, 您或许想采取适当措施以减少您的重复内容。告诉我们哪一个是您比较喜欢的网址的有效方法之一就是将其列入您的网站地图(Sitemap) 里。

- 在步骤三中,如果我们无法探测出某一特定页面的所有重复性页面的话,我们在对其页面特性进行整合时就不可能包括所有这些重复性页面的特性。这可能会削弱这一特定内容的排名竞争力,因为他们被分散分配到了多个网址上。

在 大多数情况下,谷歌可以很好的处理此类重复内容。然而,对于那些不同域名上的重复性内容,您或许需要再考虑一下。尤其是,当您决定建立一个网站而它的目的 从本质上来讲就是内容抄袭和重复的话,如果您的商业模式又依赖于搜索引擎的流量,那么除非您可以给用户带来很多的附加价值,不然对于建立此类网站您还是要 三思而后行。举个例子,我们有时听到来自Amazon.com的联盟网站说他们网站上那些完全由Amazon提供的内容很难有好的排名。这难道是因为谷歌 想阻止他们卖《Everyone Poops》 这本书吗?不;这是因为如果他们的网站提供完全一样的内容的话,他们怎么可能会比Amazon的排名更好呢?对于在线购物来讲,Amazon在很多方面具 有权威性(对于一个典型的Amazon联盟网站来说更是如此),一般的谷歌搜索用户可能想看到的是Amazon上的原始信息,除非这个联盟网站提供了相当 数量的、额外的附加值给用户。

最 后,想一下重复内容给您网站带宽带来的影响吧。重复内容会造成抓取效率低下:当Googlebot在您的网站上发现了十个网址,在它知道这些网址含有完全 相同的内容之前(如上所述,也就是在我们能够对他们进行归类之前),它必须对这十个网址逐一进行抓取。Googlebot耗费在抓取重复性内容上的时间和 资源越多,它用来抓取其他内容的时间也就相对变少了。

总而言之,网站上的重复性内容会以多种方式影响您的网站。但是除非您是恶意抄袭造成内容重复,否则这些方式不会构成对您网站的处罚。这也意味着:

跟软404代码说再见

原文: Farewell to soft 404s

发表于: 2008年8月12日星期二,下午2:54

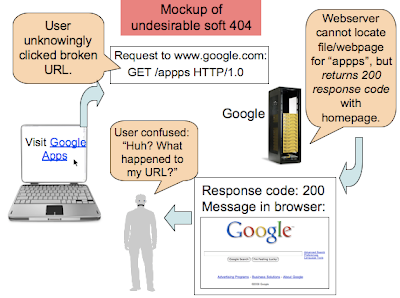

在网络上,我们可以看到两种404(”文件无法找到”)响应代码:”硬404代码”和”软404代码”。我们不鼓励使用所谓的”软404代码”,因为它们可能会对用户和搜索引擎造成困惑。对一个不存在的URL,那些提供”软404代码”的网站不是返回一个404响应代码,而是返回一个200响应代码。然而,伴随这种200响应代码的内容通常是该网站的首页或者是一个错误信息的页面。

一个软404代码的用户体验是怎样的呢?这里有一个软404代码的模型:这个网站对一个不存在的URL返回一个200相应代码以及这个网站的首页。

如上图所示,软404代码会给用户带来困惑,而且搜索引擎也会花很多时间在您的网站上爬行和索引一些并不存在、而且经常重复的URL。这会给您网站的索引覆盖率造成负面影响——由于谷歌机器人被这种代码误导并花了大量时间爬行一些并不存在的网页,您的一部分含有独特内容的网页反而有可能无法被及时发现,或者不能被经常性访问。

如果不返回一个软404代码,我应当怎么做呢?

更好的做法是返回一个404响应代码,而且向用户清晰地说明这个文件无法找到。这样做将使搜索引擎和用户都得到更愉快的体验。

返回404响应代码

向用户返回更明确的信息

我的服务器可以返回404代码,但同时向用户发送一个有帮助意义的”无法找到”的消息么?

当然可以做到!在今后的”404专题周”里您可以看到更多相关信息!

《南方都市报》评论:搜不是病,搜不着才是病

网上有篇名为《“80后”通病》的帖子,据说因为准确地概括了“80后”的症状而引起了“80后”的强烈共鸣.我感兴趣的是其中一个“通病”:“不问问 题,相信百度和谷歌的权威,多数人喜欢用搜索引擎思考,将搜索引擎作为自己的智囊.” 对此“通病”,《中国青年报》的具体描述是:“从早上一睁眼开始,去 哪儿吃早饭,坐哪路车,文案怎么写,作业怎么做,下班放学之后去哪K歌,明星们的八卦,哪个牌子的化妆品更适合自己,身体突然出现的小毛病,电影里的小细 节,甚至是回家途中偶然遇到的那只猫的品种都成了内心永远比外在火热的 ’80后’搜索的对象.”

令人疑惑的是,为什么大家都在搜索引擎前发呆,唯独“80后”生了病,而且还“通”了?

在此,有必要先说说我对时间的理解.为什么世间多说“处女地”,而不说“处女时”?在我看来,实际情形或许恰恰相反.因为时间对每个人来说都是唯一的, 每个人都只能占有属于自己的时间,因为时间永远新鲜又转瞬即逝.与每分每秒都为生命保持童贞的时间相比,空间却是“你方唱罢我登场”,成了“人尽可夫”的 古战场.遗憾的是,那些雄心勃勃的帝王可以占领天底下的良田沃土,却不可能通过杀人无数而万寿无疆.

然而,尽管我相信时间比空间更真 实,对人生更有意义,承认时间是我们现在也是最后的栖身之所,但我还是很不喜欢看到有人用“80后”或“90后 ”这样的词语来概括一代人的品质.如果人被当作某个年代的产品,并用这个年代标刻他们的人生,贴上标签,分出级别,那这个世界岂不真的进入赫胥黎与扎米亚 京笔下的乌托邦了?众所周知,在那个美好得令人发抖的世界里,生命没有任何意义,除了编号.

如上所述,对这种全称式的标签描述,我有 一种近乎本能的反感.严格说,我也不认为这种“搜索生活”是一种病.从信息获取的方式来看,我更倾向于认为这是一种社会进步,一种求知方式的变革.在上世 纪九十年代中期,我们之所以无节制地赞美刚刚进入大众生活的互联网,一个重要原因就是互联网开启了一场关于信息传播方式的革命,一场由“推”(push) 到“拉”(pull)的历史性转变.从此,我们开始告别野蛮的“推时代”,不必时刻为那点可怜的信息傻坐在电视机前,一边在心里撑起雨伞,一边逆来顺受地 接受各种广告与宣传的猛烈灌溉.

如何理解“百度和谷歌的权威”?显然,和过去“打天下”打出权威相比,“搜天下”的背后却是“权威社 会化”.人们对百度与谷歌等搜索引擎的使用与推崇,恰恰构成了对传统权威模式的一种反叛.网络时代的任何知识说到底都只是一种可以被修正的信息,而搜索引 擎所提供的亦不过一个便于寻找信息的信息平台或者市场.至于其中内容,哪些更权威更真实,哪些更实用更有益,则完全取决于搜索者自己的比较与判断.所以 说,怕只怕百度、谷歌有“通病”,怕只怕人们在所有搜索引擎里找不到有用的信息,或者只能找到“一面理”标准信息,而无其它能起“匡正”与交叉验证作用的 信息.从这方面说,“搜生活”如果有病,那不是因为搜,而是因为搜不着.只要搜索引擎是健康的,使用搜索引擎寻求知识的人也是不容易有病的.

谈到互联网上的诸种“答案”,人们首先想到的是冷冰冰的技术,却忽略了屏幕之外生活着一群群活生生的、会思考的人.我一直相信互联网是今日世界最好的大 学,十几年前,尤其是“视窗95”推出后我们似乎更能体会“每个网民都是同窗”的意味,大家可以借助网络便捷地交流与学习.时至今日,我同样相信,每个网 民也都是潜在的老师或权威,因为他随时有可能为他人提供有益的或者可被称为“答案”的信息.

众所周知,在知识极度贫困的年代,权威是 稀有动物,答案也是标准像.而现在,伴随着社会的开放,生活与思想的多元化,人们搜到的和需要的答案也是各式各样.在这个有些东西十年未改,有些东西又一 日千里的时代,我想任何一家雄视天下的搜索引擎,也不敢说自己是可以代人思考的权威,或自封为“权威界的头牌”吧.

(作者熊培云 系资深评论员)

Google 网页排名背后的技术

这是 Google 工程师 Amit Singhal 发表在 Google 官方博客的一篇文章,讲述了 Google 搜索排名背后的一些技术,涉及到 Google 对网页,对语义,对用户意图的理解。

Google 搜索排名的核心技术源自已有50年历史的学术课题 Information Retrieval (IR),IR 技术使用统计学原理对文字的使用频率等属性进行研究并对结果进行排名。建立在 IR 理论上的 Google 搜索同时借助链接,网页结构等等技术形成独特的搜索技术。

理解网页:

Google 多年来在网络爬虫与索引系统上投入巨资,因此,Google 拥有非常庞大并且是最新的网页索引,除此之外,Google 还使用一些最新技术提高索引质量,比如,他们开发了一种技术,可以在字面意思之外理解一个网页所表达的重要概念,人们使用意大利语言搜索 “galleria sprovieri londra“,会找到伦敦的 Sprovieri Gallery,尽管 Sprovieri Gallery 主页上既没有 London,也没有 Londra 字样。在美国,人们搜索 “cool tech pc vancouver, wa”,会找到 www.cooltechpc.com,然而 www.cooltechpc.com 的主页上没有任何文字表明他们位于 Vancouver。其它技术包括,区分一个网页中的重要或非重要文字,以及网页内容的新鲜度。

理解语义:

Google 可以通过用户提供的几个搜索关键词,理解用户的真实意图。他们在拼写纠正,词义,以及概念分析方面处于非常领先的位置。很多人都或多或少体验过 Google 的拼写纠正功能,比如搜索 “kofee annan“,Google 会问你搜索的是否 “kofi annan“,然而,当有人搜索 “kofee beans“,Google 会纠正成 “coffee beans”。(Google 事实上已经在尝试语义技术 – 译者)

词 义是 Google 尝试理解查询语义的基础,也是 Google 遇到的最大难题。一些在人看来显而易见的东西,机器却很难自动处理。用户并不想对使用什么词汇进行查询而费神,人们甚至压根不知道该使用什么进行查询。在 这种时候,Google 的词义系统便可以发挥作用,词义系统可以对查询语句进行非常复杂的修正,比如,查询 “Dr Zhivago” 的时候,Google 知道 Dr 代表 Doctor ,而查询 “Rodeo Dr” 的时候,Dr 代表 Drive。用户搜索 “back bumper repair” 的时候,结果是 rear bumper repair,而搜索 “Ramstein ab“,Google 能够将 ab 理解成 Air Base,”b&b ab” 会理解为 Alberta 的 Bed and Breakfasts 。Google 将这种词义理解系统发展到上百种不同语言。

Google 在搜索排名中使用的另一项技术是概念识别,该技术可以对查询的内容进行概念识别,比如,我们查询 “new york times square church“,Google 知道我们实际上查询的是纽约时代广场上的那座著名教堂,而不是纽约时报中的某篇文章。概念识别技术并不止这些,Google 还对其进行加强以正确地识别语义,比如,搜索 “PC and its impact on people“,事实上是搜索计算机对社会的影响。Google 的搜索分析算法中这类技术比比皆是,而且面向几乎所有语言。

理解用户:

Google 尝试理解用户的目的是为用户返回他们真正需要的结果,而不是他们在搜索语句中所说的东西。该技术基于一个世界级的本地化系统,外加先进的个性化技术,以及各种用户意图识别技术。

Google 对本地结果的重视体现在他们的本地化工作中。同样一个查询语句在不同国家会返回不同结果,比如,查询 “bank]”,在美国返回的是银行,而英国则可能是 Bank Fashion 的服装连锁店,或者英国的银行,而在其它英语国家,如澳大利亚,加拿大,新西兰,南非,返回的则应仍旧是当地的银行。如果你在一些非英语国家查询这个词, 象埃及,以色列,日本,俄罗斯,沙特,瑞士,返回的结果将更有趣。就象 Football 在美国和英国表示不同的运动项目一样,同一个词在不同国家查询的结果可能截然不同。

个性化查询是 Google 另一项先进搜索技术,一个已经登录的用户,如果开通了 Web History 服务,随着他查询时间的增长,Google 会根据他的查询历史,自动调整返回的结果,比如,一个经常查询 Football 相关话题的人,会逐渐从 Google 得到更多足球相关的结果。如果你青睐某个购物站返回的结果,在以后的查询中,会从那个购物站得到更多结果。

Google 在返回用户真正想要的结果方面的另一个例子是,假如你搜索 “chevrolet magnum“,我们知道 Magnum 不是 Chevrolet 产的,是 Dodge 产的,Google 会自动返回 dodge magnum 的结果。还有一个例子,有人搜索 “bangalore“,不仅返回 Bangalore 这个城市的主页,而且返回 Bangalore 的地图,以及一些与 Bangalore 市景,交通相关的视频,这些视频会让你有身临其境的感觉。

本文国际来源:http://googleblog.blogspot.com/2008/07/technologies-behind-google-ranking.html

中文翻译:COMSHARP CMS

用搜索引擎机器人的语言交流

发表者:Sean Harding,网站管理员工具小组原文:Speaking the language of robots

发表于:2008年3月27日星期四,下午1:27我们都知道

谷歌机器人是非常友好的。就像所有的友好的搜索引擎机器人一样,他耐心地听取我们的意见并且尊重我们的意愿不去爬行任何我们不希望它爬行的网站部分。我们可以仅仅给他一个robots.txt文件说明什么是我们希望他做的,然后他就会愉快地遵从。但是如果我们迫不得已只能与谷歌机器人直接交流呢?毕竟,不是所有的人都熟悉robots.txt文件的语言。这就是我们为什么如此高兴地向您介绍一款专属于您的搜索引擎机器人翻译工具:网站管理员工具中的robots.txt生成器。它旨在为您提供一个既简单又互动的方式去建立一个robots.txt文件。它的操作非常简单,您只需输入您不希望搜索引擎机器人爬行的文件和目录即可。 或者,如果您需要的话,您可以为特定的搜索引擎机器人或您网站的特定区域建立更加细致的规则。

或者,如果您需要的话,您可以为特定的搜索引擎机器人或您网站的特定区域建立更加细致的规则。

当您完成了对生成器的配置之后,您可以利用我们的 robots.txt分析工具检测新生成的robots.txt文件的效果。如果测试无误,您只需将生成的文件保存在您网站的根目录下即可。除此之外,这里还有一些关于robots.txt文件的重要事实希望您能牢记:

- 不是所有的搜索引擎都支持robots.txt文件的所有扩展Robots.txt生成器可以生成谷歌机器人能够理解和识别的文件,而且绝大多数搜索引擎机器人也都能够正确识别。但是,一些例外情况也是存在的,或许有一些搜索引擎机器人不能完全识别生成器生成的所有特性。

- Robots.txt文件仅仅是一个请求尽管在主要搜索引擎上极为少见,搜索引擎中还是有一些肆无忌惮的搜索引擎机器人会无视robots.txt的内容,对禁止访问的网站区域也进行爬行。如果您有一些需要进行彻底保护的敏感信息,您应该设置访问密码来对它们加以保护,而不是仅仅依赖于robots.txt文件。

我们希望这个新工具能够帮助您将自己的意愿与谷歌机器人和其他访问您网站的搜索引擎机器人进行更顺畅的沟通。如果您想了解更多关于robots.txt文件的情况,请访问我们的帮助中心。如果您想就robots.txt和搜索引擎机器人的有关问题与其他网站管理员进行交流的话,请访问我们的谷歌网站管理员支持论坛。

转载自谷歌中文网站管理员博客

与谷歌机器人的第一次约会:标头和压缩

发表者:Maile Ohye (饰网站),Jeremy Lilley (饰谷歌机器人)

原文: First date with the Googlebot: Headers and compression

发表于: 2008年3月5日星期三,晚上6:13

姓名/用户代理: 谷歌机器人

IP地址: 点击这里查看如何验证

寻觅: 拥有独特而诱人内容的网站

最不喜欢的行为:违反《网站管理员指南》

谷歌机器人 — 多么神奇的梦幻之舟!他了解我们的灵魂和各个组成部分。或许他并不寻求什么独一无二的东西;他阅览过其它数十亿个网站(虽然我们也与其他搜索引擎机器人分享自己的数据:)),但是就在今晚,作为网站和谷歌机器人,我们将真正地了解对方。

我知道第一次约会的时候,过分地分析从来就不是什么好主意。我们将通过一系列的文章,一点点地了解谷歌机器人:

- 我们的第一次约会(就在今晚):谷歌机器人发出的数据标头和他所留意到的文件格式是否适于被进行压缩处理;

- 判断他的反应:响应代码(301s、302s),他如何处理重定向和If-Modified-Since;

- 下一步:随着链接,让他爬行得更快或者更慢(这样他就不会兴奋地过了头)。

今晚只是我们的第一次约会……

***************

谷歌机器人: 命令正确应答

网站: 谷歌机器人,你来了!

谷歌机器人:是的,我来了!

GET / HTTP/1.1

Host: example.com

Connection: Keep-alive

Accept: */*

From: googlebot(at)googlebot.com

User-Agent: Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Accept-Encoding: gzip,deflate

网站: 这些标头太炫了!无论我的网站在美国、亚洲还是欧洲,你都用同样的标头爬行吗?你曾经用过其他标头吗?

谷歌机器人: 一般而言,我在全球各地所用的标头都保持一致。我试图从一个网站默认的语言和设定出发,搞清楚一个网页究竟长得什么样。有时候人们的用户代理各不相同,例如Adsense读取使用的是“Mediapartners-Google”:

User-Agent: Mediapartners-Google

或者对于图像搜索:

User-Agent: Googlebot-Image/1.0

无线读取的用户代理因运营商而异,而谷歌阅读器RSS读取则包含了订阅者数量等额外信息。

我通常会避免Cookies(因此不存在所谓“Cookie:”标头),因为我并不希望与具体对话有关的信息对内容产生太大的影响。此外,如果某个服务器在动态URL而不是Cookies上使用对话ID,通常我都能识别出来,这样就不用因为每次对话ID的不同而成千上万遍地重复爬行同一个网页。

网站:我的结构非常复杂。我是用许多类型的文件。你的标头说:“Accept:*/*”。你会对所有的URL进行收录,还是自动过滤某些文件扩展名?

谷歌机器人:这要取决于我想找什么。

如果我只是对常规的Web搜索进行检索,当我看到指向MP3和视频内容的链接,我可能不会下载这些东西。类似地,如果我看到了一个JPG文件,处理方法自然 就与HTML或者PDF链接有所区别。例如JPG 的变动频率往往比HTML低很多,所以我不太经常检查JPG的变动,以节约带宽。同时,如果我为谷歌学术搜索寻找链接,那么我对PDF文章的兴趣就会远远高于对JPG文件的兴趣。对于学者而言,下载涂鸦绘画(例如JPG),或者是关于小狗玩滑板的视频,是容易让他们分散注意力的,你说对吗?

网站:没错,他们可能会觉得被打扰到了。你的敬业精神令我佩服得五体投地。我自己就喜欢涂鸦绘画(JPG),很难抗拒它们的诱惑力。

谷歌机器人:我也一样。实际上我并不是一直都在做学问。如果我为搜索图像而爬行,就会对JPG非常感兴趣,碰到新闻,我会花大力气考察HTML和它们附近的图像。

还有很多扩展名,例如exe、dll、zip、dmg等,它们对于搜索引擎而言,既数量庞大,又没有多大用处。

网站:如果你看到我的URL“http://www.example.com/page1.LOL111”,(呜噎着说)你会不会只是因为里面包含着未知的文件扩展名就把它拒之门外呢?

谷歌机器人: 网站老兄,让我给你讲点背景知识吧。一个文件真正下载完成后,我会使用“内容—类别”(Content-Type)标头来检查它属于HTML、图像、文本还是别的什么东西。如果它是PDF、Word文档或Excel工作表等特殊的数据类型,我会确认它的格式是否合法有效,并从中抽取文本内容。但是你永远也不能确定里面是否含有病毒。但是如果文档或数据类型混乱不清,我除了把它们扔掉之外,也没有什么更好的办法。

所以,如果我爬行你的“http://www.example.com/page1.LOL111”URL并发现未知文件扩展名时,我可能会首先把它下载。 如果我从标头中无法弄清内容类型,或者它属于我们拒绝检索的文件格式(例如MP3),那么只能把它放在一边了。除此之外,我们会接着对文件进行爬行。

网站:谷歌机器人,我很抱歉对你的工作风格“鸡蛋里挑骨头”,但我注意到你的“Accept-Encoding”标头这样说:

Accept-Encoding: gzip,deflate

你能跟我说说这些标头是怎么回事吗?

谷歌机器人:当然。所有的主流搜索引擎和WEB浏览器都支持对内容进行gzip压缩,以节约带宽。你或许还会碰到其它的一些类型,例如“x-gzip”(与“gzip”相同),“deflate”(我们也支持它)和“identity”(不支持)。

网站:你能更详细地说说文件压缩和“Accept-Encoding: gzip,deflate”吗?我的许多URL都包含尺寸很大的Flash文件和美妙的图像,不仅仅是HTML。如果我把一个比较大的文件加以压缩,会不会有助于你更迅速地爬行呢?

谷歌机器人:对于这个问题,并没有一个简单的答案。首先,swf(Flash)、jpg、png、gif和pdf等文件格式本身已经是压缩过的了(而且还有专门的Flash 优化器)。

网站:或许我已经把自己的Flash文件进行了压缩,自己还不知道。很显然,我的效率很高喽。

谷歌机器人:Apache和IIS都提供了选项,允许进行gzip和deflate压缩,当然,节省带宽的代价是对CPU资源的更多消耗。一般情况下,这项功能只适用于比较容易压缩的文件,例如文本HTML/CSS/PHP内容等。而且,只有在用户的浏览器或者我(搜索引擎机器人)允许的情况下才可以使用。 就我个人而言,更倾向于“gzip”而不是“deflate”。Gzip的编码过程相对可靠一些,因为它不断地进行加和检查,并且保持完整的标头,不像 “deflate”那样需要我在工作中不断推测。除此之外,这两种程序的压缩算法语言都很相似。

如果你的服务器上有闲置的CPU资源,可以尝试进行压缩(链接:Apache, IIS)。但是,如果你提供的是动态内容,而且服务器的CPU已经处于满负荷状态,我建议你还是不要这样做。

网站:很长见识。我很高兴今晚你能来看我。感谢老天爷,我的robots.txt文件允许你能来。这个文件有时候就像对自己的子女过分保护的父母。

谷歌机器人:说到这里,该见见父母大人了——它就是robots.txt。我曾经见过不少发疯的“父母”。其中有些实际上只是HTML错误信息网页,而不是有效的robots.txt。有些文件里充满了无穷无尽的重定向,而且可能指向完全不相关的站点。另外一些体积庞大,含有成千上万条单独成行、各不相同的 URL。下面就是其中的一种有副作用的文件模式,在通常情况下,这个站点是希望我去爬行它的内容的:

User-Agent: *

Allow: /

然而,在某个用户流量的高峰时段,这个站点转而将它的robots.txt切换到限制性极强的机制上:

# Can you go away for a while? I’ll let you back

# again in the future. Really, I promise!

User-Agent: *

Disallow: /

上述robots.txt文件切换的问题在于,一旦我看到这种限制性很强的robots.txt,有可能使我不得不把索引中已经爬行的该网站内容舍弃掉。当我再次被批准进入这个站点的时候,我不得不将原先的许多内容重新爬行一遍,至少会暂时出现503错误相应代码。

一 般来说,我每天只能重新检查一次robots.txt(否则,在许多虚拟主机站点上,我会将一大部分时间花在读取robots.txt文件上,要知道没有 多少约会对象喜欢如此频繁地拜见对方父母的)。站长们通过robots.txt 切换的方式来控制爬行频率是有副作用的,更好的办法是用网站管理员工具将爬行频率调至“较低”即可。

谷歌机器人: 网站老兄,谢谢你提出的这些问题,你一直做得很不错,但我现在不得不说“再见,我的爱人”了。

网站:哦,谷歌机器人…(结束应答):)

***************

Google发布管理员支持论坛中文版

发表者:李露

今天,Google 正式推出中文版网站管理员支持论坛 。目前,Google 网站管理员支持论坛已经拥有了包括英文、德文、法文在内的多达二十种语言版本。此次中文版论坛的建立旨在为中文站长们提供一个互相交流和与 Google 工作人员直接交流的平台。你会发现一些成员的名字旁有蓝色 G 标志,这代表此用户是来自 Google 网站管理员支持小组以及搜索质量小组的成员,他们会参与部分讨论,回答网站管理员普遍关心的问题并维护论坛。我们欢迎更多站长和业内人士加入我们,将你在建站和搜索引擎抓取收录等方面的经验与大家分享,成为论坛的粉丝用户(我们称那些积极发帖为论坛成员提供建议和帮助的活跃分子为“粉丝用户”)。

值得强调的两点是:1. 只有名字前带有蓝色 G 标志的才是来自 Google 的成员,他们有包括删垃圾贴的权利;2. 我们为大家准备了详细的 Google 攻略,在发帖提问前不妨先尝试利用现有资源或在论坛内找找看,这样您可以在第一时间得到答案,也避免了资源的浪费。

我们在论坛首页已经列出了 Google 专为站长提供的资源链接, 这里再简要介绍一下:

Google 网站管理员中心 - 站长资源的集中站。这里提供了包括网站管理员工具,帮助中心,管理员博客等的链接。是通向所有 Google 为站长专设服务的大门。

Google网站管理员工具 - Google 对网站抓取和索引编制的统计、诊断和管理,包括 Sitemap 提交和报告。关于管理员工具的使用,在《 Google(谷歌)的网站优化利器—中文网站管理员工具》 已有详述。

Google 网站管理员博客 – 有关 Google 如何抓取网站并编制索引的最新资讯和信息。有来自 Google 的资深工程师、搜索质量小组成员发表的文章,同时,也有译自英文网管博客以及 Matt Cutts 博客中的文章。

Google 网站管理员支持中心 - 为中文管理员专设的支持中心,涵盖了关于抓取、编制索引、排名和其他网站管理员问题的常见问题解答。我们非常鼓励管理员充分利用该帮助中心,并通过反馈为我们提出内容和形式上改进的建议。

Google工具条PR更新与排名变化的迷思

这几天Google工具条PR又在更新了。我感觉更新还没结束,显示PR数据准确性很值得怀疑。

现在对Google PR更新本身越来越不感兴趣了。因为基本上没有大的造链接活动,PR值也不会有什么太大变化了。不过看到网上有一些关于PR更新及网页在Google中排名变化的一些迷思,觉得还是有必要把自己的一些理解跟大家介绍一下。

Google工具条PR不是真实的PR

大家所看到的工具条上显示的绿色条,更准确的应该称为可见的工具条PR值,而不是Google内部用于排名计算的真实PR值。

Google真正使用的PR值是连续不停的计算的,并不是每三个月或两个月改变一次。我们看到的工具条PR是一段时间以前(比如两个月或三个月)某一个时间点的PR值输出。所以我们现在看到的工具条PR值,已经是两三个月前的数据。现在真实的PR值是多少是无法知道的。

另外,工具条上显示的PR值是否是输出时真实的PR值,我也表示怀疑。不仅是这次更新,从很多次更新的情况看,要么Google有意不告诉我们真实PR值,要么很多网站的数据出现了错误。

Google工具条PR更新与排名变化没有时间对应关系

在论坛里看到不少人说,Google PR值更新,网站PR提高了一或二,怪不得这几天排名也上升了。

其实Google工具条PR更新与Google排名之间没有时间上的对应关系。像上面说的,真实的PR是连续不停计算的,而且是随时被计入排名算法的。更新后我们看到的工具条PR值所带来的效应在几个月前就已经被计入排名了。

所以不要从工具条PR值上升,来判断对网页排名有什么影响。如果你同时看到工具条PR值上升和排名上升,最好找其他原因,这是时间上的巧合,而并没有直接因果关系。

Google PR只与链接有关

经常看到博客留言或论坛中有人说,我的网站已经两年了,为什么PR还是零呢?或者,我的网站内容全是原创,为什么PR还是零呢?

原因是,PR值与站长是否认真,内容是否原创,网站设计怎么样,甚至与域名年龄,都没有直接关系。

PR的计算只是根据反向链接,进来的链接越多,这些链接页本身的投票力越高,你的网页PR值就越高。所以就算你的域名已经十年了,如果没有反向链接,PR值也高不了。

最近几个月有可能出现一些看似的例外。有的网站因为付费链接问题被惩罚,PR值要么下降,要么清零。目前不知道这些网站PR值变化是人工调整,还是因为算法检测出付费链接后取消某些链接的投票力,而造成与之相关的其他网站PR值变化。总之,还是与链接有关。

Google已经不跳舞很久了

在论坛里还会看到有人用Google dance这个词,有的专家到现在也还在说Google dance。

其实Google已经不dance很久了。

Google dance这个词是数年前形容Google每个月一次大更新而创出来的词。那时候的Google更新,是网页数据库,算法,各数据中心之间的同步全部发生彻底变化。Google已经不进行这种dance四年多了。

现在的排名变化更多的是因为算法更新或数据刷新而引起的。而且算法更新现在的特点是小规模不停的调整(everflux),那种大规模的更新已经十分十分少见。

以前的真正的Google dance和现在的排名变化特征并不相同。所以用Google dance这个词对某些初学者来说可能有误导。

作者: Zac@中新虚拟主机

原载: 点石互动搜索引擎优化博客

版权所有,转载时必须以链接形式注明作者和原始出处及本声明。

Google搜索结果里再加搜索框?

从blogoscoped报道,Google搜索结果又添新花样。

Google搜索结果中有时出现sitelinks,今天对出现sitelinks的一些网站下面又出现了一个搜索框。比如搜索“新浪”:

在搜索框里再搜索,相当于直接搜索“关键词 site:sina.com.cn”,也就是在sina.com.cn站内搜索:

目前看来只是有sitelinks的站才加这个搜索框。但不是所有有sitelinks的站都加,点石就没有:

这个功能大概还在测试中,Philipp自己还看不到这个搜索框,有人说只在美国能看到,有人说不是。至少我在新加坡能看到。只在google.com出现,在google.cn还没有。

域名的权威度越来越重要了,不仅对排名重要,出现在搜索结果中也越来越醒目。

作者: Zac@中新虚拟主机

原载: 点石互动搜索引擎优化博客

版权所有,转载时必须以链接形式注明作者和原始出处及本声明。

Google的unavailable_after标签的使用方法

上周我们预告了Google将会增加一个新的Meta标签“unavailable_after”,它允许我们手动指定某个网页的失效日期,以提醒Google的爬虫在该日期后不再抓取含该标签的网页。不过上周我们并不清楚这个标签到底是怎样使用的。SEL今天从Google的产品经理Dan Crow那里了解到这个标签的详情用法,下面和大家分享一下。

要使用“unavailable_after”标签,只需要在网页的头部加入以下的Meta语句即可:

< META NAME=”GOOGLEBOT” CONTENT=”unavailable_after: 日期 时间 时区” >

其中的日期、时间、时区(缩写)分别用23-Jul-2007、19:18:17、EST这种格式。当Google的爬虫看到网页里包含这个标签时,它不仅会不再抓取这个网页,还会在一天左右的时间内将网页从Google的搜索结果里除去。值得注意的是,Google Cache里的相关的网页快照依然会存在。要想移除Google Cache里的记录,得给网页加上noarchive标签。

本文转载自:G速客原文地址:Google的“unavailable_after”标签的详细使用方法